Comment fonctionne Google

Dans un monde où l’accès à l’information se doit d’être rapide, précis et pertinent, les moteurs de recherche jouent un rôle capital dans la gestion du flux gigantesque de contenu disponible en ligne. Google, incontestablement le leader mondial, transforme chaque requête en une expérience fluide et personnalisée. Mais comment, derrière cette simplicité apparente, fonctionne réellement cet outil d’une complexité fascinante ? De l’exploration des milliards de pages web à l’affichage instantané des résultats, la chaîne de processus qui sous-tend Google témoigne d’une orchestration technologique farouchement innovante et méthodique.

La quête de pertinence dans chaque réponse pousse Google à sans cesse raffiner ses algorithmes et infrastructures. Les enjeux sont multiples : traiter une masse invraisemblable de données, lutter contre la désinformation, favoriser la diversité des résultats tout en restant rapide, et s’adapter aux nouvelles tendances de recherche imposées par des utilisateurs toujours plus exigeants et variés. Par ailleurs, Google n’est pas seul sur ce marché. D’autres acteurs comme Bing, Yahoo ou DuckDuckGo, avec leurs particularités, viennent enrichir cette compétition technologique où chaque moteur affine sa spécialité.

Comprendre le mécanisme en profondeur suppose d’analyser chaque étape majeure : l’exploration (crawling), l’indexation, le ranking, puis la restitution. Chaque phase repose sur des technologies de pointe, assorties de décisions stratégiques pour filtrer et hiérarchiser des contenus numériques inégalés. Finalement, c’est cette complexité cachée qui permet à Google de continuer à dominer un secteur crucial de l’ère numérique, tout en innovant pour mieux répondre aux besoins des utilisateurs et anticiper les mutations futures du web.

Exploration du web : comment Google collecte et organise les milliards de pages

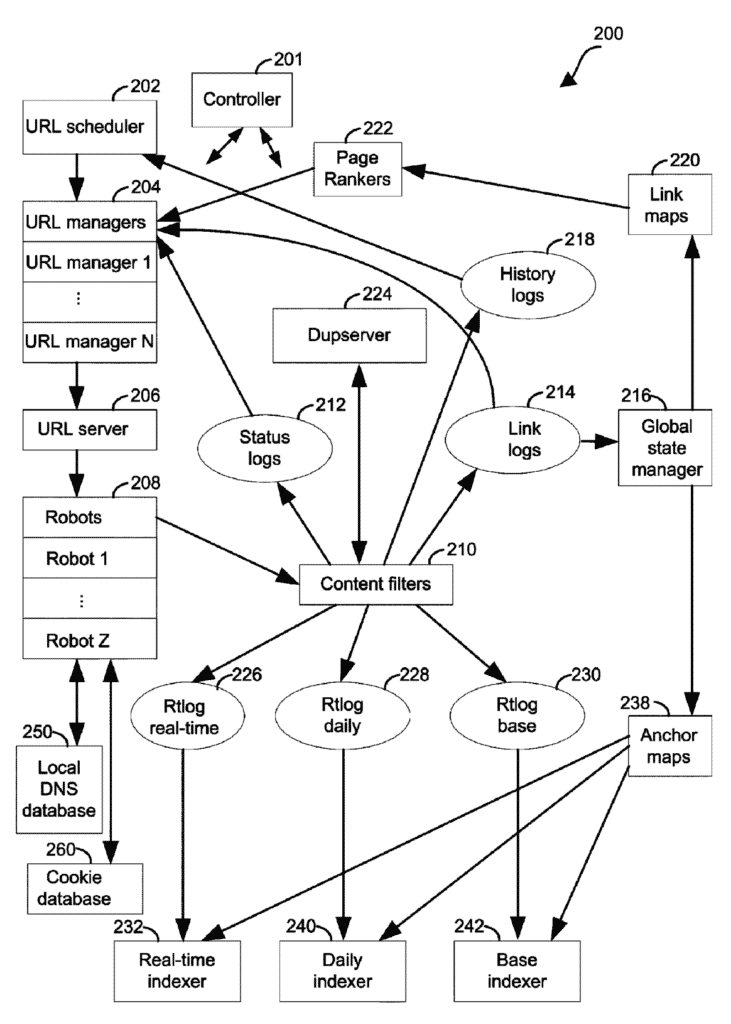

L’une des premières étapes indispensables dans le fonctionnement de Google est l’exploration, également nommée crawling. Cette phase consiste en un parcours systématique du web à l’aide de robots spécialisés appelés crawlers ou Googlebots. Ils parcourent sans relâche des milliards de pages, images, vidéos, documents et autres ressources pour en extraire des informations exploitables.

Pour réaliser cette tâche gigantesque, Google répartit son crawl sur un ensemble massif de serveurs et de centres de données répartis mondialement, garantissant ainsi une couverture complète et à jour du web. Chaque crawler suit les liens présents sur les pages visitées pour en découvrir d’autres, créant une sorte d’arborescence infinie qui explore en profondeur l’immense bibliothèque numérique qu’est Internet.

Par exemple, lorsqu’un nouveau site est lancé ou qu’une page est mise à jour, les crawlers détectent ces modifications afin d’ajouter ou de modifier les informations dans l’index de recherche. Ce processus continu permet de maintenir l’index de Google aussi frais et complet que possible.

- Identification des URLs via les liens hypertextes

- Évaluation de la fréquence de crawl selon l’importance ou la mise à jour du contenu

- Prise en compte des fichiers robots.txt pour respecter les directives des sites web

- Traitement prioritaire des pages susceptibles d’avoir un fort impact sur les recherches des utilisateurs

Les différentes étapes du crawling peuvent rencontrer des obstacles comme des liens morts, des pages protégées ou à contenu dupliqué, que Google doit identifier pour optimiser l’exploration. D’autres moteurs comme Bing ou Baidu opèrent également selon des méthodes similaires, mais la sophistication du crawl chez Google reste un élément distinctif majeur.

| Aspect du crawling | Description | Impact sur la qualité des résultats |

|---|---|---|

| Présélection des URLs | Identification via liens internes et externes | Garantie d’une couverture importante des ressources pertinentes |

| Fréquence de visite | Actualisation basée sur changements détectés | Maintien à jour des informations pour des recherches récentes |

| Respect des consignes robots.txt | Non-exploration des pages interdites par site | Respect de la confidentialité et des stratégies webmasters |

| Gestion des erreurs | Détection des pages inaccessibles ou dupliquées | Optimisation de la qualité globale de l’index |

Le résultat de cette étape est une gigantesque base de données indexée, comparable à la plus grande bibliothèque mondiale jamais conçue. Cet index n’est pas statique; il se renouvelle constamment pour s’adapter aux nouvelles tendances du web et garantir des résultats pertinents aux utilisateurs en temps réel (cf. fonctionnement officiel de Google).

Les moteurs alternatifs à Google : une diversité d’approches dans le crawl

Si Google domine le marché, d’autres moteurs comme Bing, Yahoo, DuckDuckGo ou Qwant proposent leur propre version du crawl, souvent avec des priorités différentes, par exemple axées sur la protection des données personnelles ou le respect accru de l’environnement.

DuckDuckGo, par exemple, met fortement l’accent sur la confidentialité de l’utilisateur, rejetant le tracking des recherches. Qwant, originaire d’Europe, insiste davantage sur la neutralité des résultats et l’indépendance par rapport aux géants américains.

Ces différences d’approche se traduisent donc par des variations dans la mise à jour de l’index et la couverture des contenus. Toutefois, la base technique commune demeure : sans crawlers efficaces et méticuleux, aucun moteur ne pourrait proposer une recherche pertinente.

Indexation et traitement des données : la mise en ordre des milliards d’informations capturées par Google

Une fois les données collectées, la deuxième phase essentielle est l’indexation. Cette étape revient à organiser et classer toutes les informations issues du crawling pour pouvoir les interroger rapidement et efficacement lors d’une recherche. On peut comparer l’index de Google à une gigantesque bibliothèque numérique qui stocke une quantité extraordinaire d’éléments.

L’indexation implique plusieurs processus complexes :

- Analyse du contenu pour identifier les mots-clés, les synonymes, et la thématique générale

- Extraction des métadonnées comme la date, l’auteur, ou des caractéristiques spécifiques (image, vidéo)

- Traitement du langage naturel pour comprendre le contexte et les intentions des pages

- Détection du contenu dupliqué et tri pour éviter les redondances dans les résultats

- Association avec des signaux externes tels que la notoriété du site et les backlinks

Grâce au progrès des technologies d’intelligence artificielle, notamment les modèles de traitement du langage naturel, l’indexation ne repose plus uniquement sur des mots-clés exacts mais sur une compréhension plus fine et sémantique des contenus. C’est ce qui permet à Google d’affiner la pertinence des résultats selon les intentions de l’utilisateur.

| Processus d’indexation | Fonction détaillée | Objectif visé |

|---|---|---|

| Extraction des mots-clés | Identification des termes clés du contenu | Repérer les thématiques principales pour indexer correctement |

| Analyse sémantique | Comprendre le contexte et le sens des textes | Accroître la précision des résultats |

| Évaluation des métadonnées | Collecte d’infos additionnelles : images, vidéos, dates | Améliorer la richesse de l’index |

| Filtrage des doublons | Élimination des contenus redondants | Optimiser l’expérience utilisateur, éviter la répétition |

L’ensemble de ces mécanismes confère à Google un avantage de premier ordre dans la capacité à fournir des contenus variés, qui vont bien au-delà du simple texte : vidéos intégrées, images de qualité (comme celles provenant de banques spécialisées telles que Giphy), actualités et même livres numériques.

L’influence croissante de l’intelligence artificielle dans l’indexation

Avec les évolutions depuis l’introduction de systèmes comme BERT, Google a déployé ses capacités en intelligence artificielle pour mieux capter le sens implicite des requêtes et des documents. Cette capacité est primordiale surtout face à des recherches complexes, des langues multiples, ou des contenus en constante évolution.

L’indexation intelligente favorise aussi la lutte contre le spam, le contenu biaisé ou les tentatives de manipulation SEO, ce qui se révèle essentiel dans un contexte concurrentiel où d’autres acteurs comme Ecosia ou Yandex progressent avec leurs propres stratégies d’indexation.

Algorithmes de classement : comment Google décide de la pertinence des résultats affichés

Après l’indexation, la question centrale devient : comment classer et présenter les résultats ? C’est la mission du ranking, phase cruciale où chaque page est évaluée selon des centaines de critères uniques déterminés par des algorithmes complexes.

Google utilise notamment des algorithmes propriétaires comme PageRank, qui mesure la popularité et la qualité des liens entrants, ainsi que des dizaines d’autres signaux incluant :

- La qualité du contenu (profondeur, originalité, actualité)

- Le comportement des utilisateurs (taux de clics, taux de rebond)

- La compatibilité mobile et la vitesse de chargement

- La localisation géographique et la personnalisation selon l’historique

- Les signaux sociaux indirects issus de plateformes variées

Par rapport à d’autres moteurs, Google excelle dans ce tri multidimensionnel. Par exemple, Adimeo détaille la complexité de ces algorithmes qui évoluent constamment pour pénaliser les pratiques abusives tout en récompensant la valeur réelle.

| Critère de classement | Description | Importance pour le ranking |

|---|---|---|

| Backlinks de qualité | Références provenant de sites populaires et fiables | Très élevée |

| Contenu original et pertinent | Textes uniques répondant précisément à la requête | Élevée |

| Engagement utilisateur | Analyse du comportement sur la page | Moyenne |

| Compatibilité mobile | Adaptation aux terminaux mobiles | Élevée |

| Vitesse de chargement | Temps nécessaire pour afficher la page | Élevée |

Pour une vision comparative, des moteurs alternatifs comme Seznam (popularité en Europe de l’Est) ou Baidu (marché chinois) appliquent également des critères spécifiques adaptés à leurs utilisateurs, mais avec souvent moins d’impact sur la personnalisation géographique ou comportementale.

Processus de restitution des résultats : de la requête utilisateur à la page affichée

L’ultime étape est celle où Google transforme la requête tapée par l’utilisateur en résultats affichés sur l’écran : la restitution. Cette phase rapide et invisible repose sur un système de traitement en temps réel, optimisé au milliseconde près.

Lorsqu’un terme est recherché, Google consulte immédiatement son index, analyse la requête avec des algorithmes sophistiqués capables de comprendre le sens et l’intention, puis calcule le classement des documents en fonction des critères exposés précédemment.

Ce processus permet d’afficher en une fraction de seconde des pages web, des images, des vidéos, des actualités, voire des réponses directes (extraits enrichis, featured snippets).

- Interpretation sémantique des requêtes pour mieux capturer l’intention

- Prise en compte du contexte utilisateur (localisation, historique, device)

- Présentation variée : résultats web, cartes, vidéos, images (intégrant Giphy par exemple)

- Affichage de fonctionnalités avancées : Knowledge Graph, calculatrices, traducteur

Grâce à cette restitution dynamique, Google se différencie nettement d’autres moteurs qui peuvent proposer des résultats plus statiques ou moins pertinents selon le contexte. Cette expérience utilisateur enrichie est la clé de sa domination continue.

| Aspect de la restitution | Description | Valeur ajoutée utilisateur |

|---|---|---|

| Interprétation | Analyse sémantique pour capter le sens exact de la recherche | Précision accrue des résultats |

| Personnalisation | Adaptation selon contexte et historique utilisateur | Recommandations plus pertinentes |

| Variété des formats | Résultats multiples : pages, vidéos, images, actualités | Expérience enrichie |

| Fonctions avancées | Snippets, Knowledge Graph, outils instantanés | Gain de temps et praticité |

Différences importantes avec d’autres moteurs comme Ecosia ou Yahoo

Le mode de restitution peut varier. Ecosia, par exemple, met en avant son engagement écologique, en affichant des publicités génératrices de revenus pour planter des arbres. Yahoo conserve une interface plus classique et moins personnalisée, appréciée par certains utilisateurs.

Ces distinctions influent sur la façon dont les résultats sont hiérarchisés et présentés, démontrant l’étendue des possibilités techniques selon les objectifs de chaque moteur, tout en soulignant le leadership technologique de Google dans le domaine.

Les innovations technologiques et l’impact des moteurs de recherche sur la société numérique

Google se réinvente constamment au rythme des avancées technologiques et des besoins sociétaux. Parmi les innovations majeures récentes, on trouve l’intégration poussée de l’IA pour anticiper les questions, proposer des réponses vocales via Assistant, ou encore améliorer la lutte contre les fake news.

En parallèle, Google doit composer avec la régulation croissante, la protection des données personnelles, et la diversité des usages dans un monde globalisé – enjeux auxquels répondent aussi d’autres moteurs privés ou publics, tels que Yandex en Russie ou Seznam en Europe Centrale.

- Amélioration des résultats par intelligence artificielle : modèles de langage développés pour plus de pertinence

- Focus sur la confidentialité : alternative avec DuckDuckGo ou Qwant

- Lutte contre les biais algorithmiques : ajustements permanents des critères de ranking

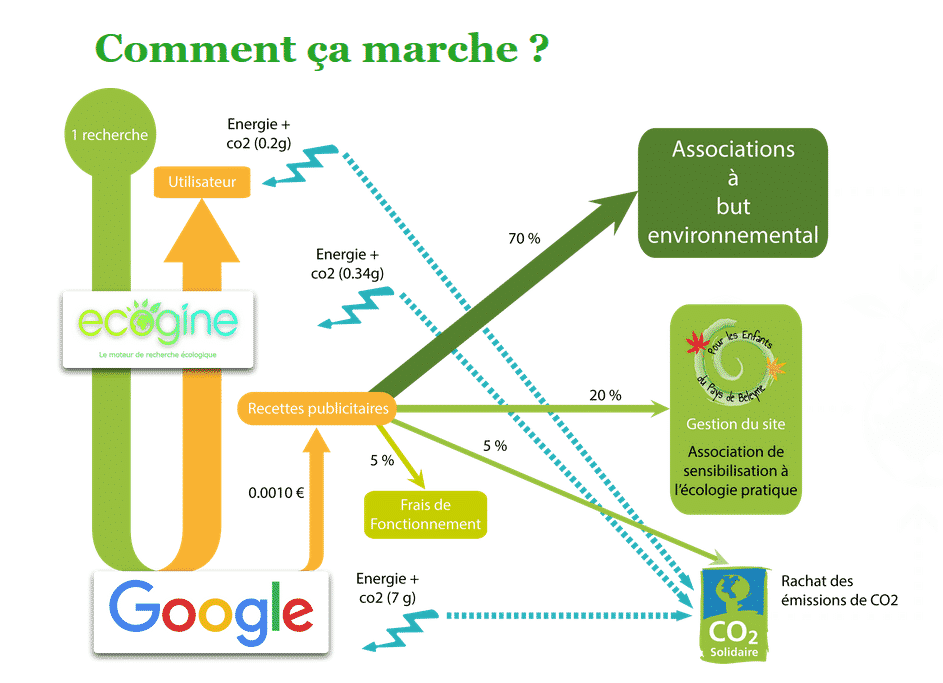

- Impact environnemental : serveurs plus verts et moteurs écologiques comme Ecosia

Ces avancées bousculent non seulement la manière dont les informations sont accessibles, mais influencent aussi la manière dont les sociétés interagissent avec la connaissance, l’opinion publique et même la culture numérique globale (cf. explications approfondies sur le fonctionnement de Google).

| Innovation technologique | Description | Conséquence sociétale |

|---|---|---|

| Intelligence artificielle appliquée | Amélioration de la compréhension et du ranking des contenus | Résultats plus pertinents et personnalisés |

| Respect de la vie privée | Options de recherche sans tracking (ex : DuckDuckGo) | Meilleure protection des données utilisateurs |

| Optimisation écologique | Valorisation des data centers à faible consommation | Réduction de l’empreinte carbone du web |

| Lutte contre la désinformation | Filtrage des fausses informations et contenus biaisés | Meilleure qualité de l’information disponible |

FAQ sur le fonctionnement détaillé de Google et des moteurs de recherche

- Comment Google parvient-il à explorer autant de pages web ?

Grâce à une armée de robots appelés crawlers, Google suit les liens entre pages de manière continue, répartissant la charge sur des serveurs puissants répartis mondialement. - Quelle différence entre indexation et crawling ?

Le crawling est la collecte des données, tandis que l’indexation consiste à organiser et classer ces informations pour qu’elles soient rapidement accessibles. - Pourquoi les algorithmes de Google changent-ils si souvent ?

Pour améliorer la pertinence des résultats, s’adapter aux nouvelles pratiques en ligne et lutter contre le spam et les manipulations SEO. - Comment Google personnalise-t-il les résultats ?

En se basant sur le contexte de l’utilisateur, comme sa localisation, son historique de recherche et son appareil, pour offrir une expérience unique. - Peut-on se fier totalement à Google pour toutes les recherches ?

Il est recommandé de diversifier ses sources, notamment en comparant avec d’autres moteurs comme Bing, Yahoo ou Ecosia, pour obtenir une vision plus complète.

Pour approfondir, consultez notamment ces ressources détaillées sur le fonctionnement de Google et les multiples analyses disponibles sur Facem Web ou Seotexte.